$$

\newcommand{\SetN}{\mathbb{N}}

\newcommand{\SetR}{\mathbb{R}}

\newcommand{\SetC}{\mathbb{C}}

\newcommand{\SetK}{\mathbb{K}}

\newcommand{\SetZ}{\mathbb{Z}}

\newcommand{\SetQ}{\mathbb{Q}}

\newcommand{\SetU}{\mathbb{U}}

\newcommand\ds[0]{\displaystyle}

\newcommand\PCar[1]{\large{\chi}_{#1}}

\newcommand{\=}{\:=\:}

\newcommand\tendvers[2]{\displaystyle\mathop{\longrightarrow}_{#1\rightarrow#2}}

\newcommand\tr[0]{\:^t\!}

\newcommand\limite[2]{\displaystyle\mathop{\text{lim}}_{#1\rightarrow#2}\:}

\newcommand\Sup[1]{\displaystyle\mathop{sup}_{#1}}

\newcommand\Inf[1]{\displaystyle\mathop{inf}_{#1}}

\newcommand\Haut[1]{}

\newcommand\vect[1]{\overrightarrow{#1}}

\newcommand\tendversCU[0]{\:\displaystyle\mathop{\Large\longrightarrow}_{n\rightarrow+\infty}^{_{CU}}\:}

\newcommand\tendversCS[0]{\:\displaystyle\mathop{\Large\longrightarrow}_{n\rightarrow+\infty}^{_{CS}}\:}

\newcommand\tendversCN[0]{\:\displaystyle\mathop{\Large\longrightarrow}_{n\rightarrow+\infty}^{_{CN}}\:}

\newcommand\tendversCUS[0]{\:\displaystyle\mathop{\Large\longrightarrow}_{n\rightarrow+\infty}^{_{CUS}}\:}

\newcommand\tendversNorme[1]{\:\displaystyle\mathop{\Large\longrightarrow}_{n\rightarrow+\infty}^{#1}\:}

\newcommand\simL[0]{\displaystyle\mathop{\sim}_{^{^L}}}

\newcommand\simC[0]{\displaystyle\mathop{\sim}_{^{^C}}}

\newcommand\simLC[0]{\displaystyle\mathop{\sim}_{^{^{LC}}}}

\newcommand\fonction[5]{

\begin{array}{cccc}

#1\::\:& #2 & \rightarrow & #3 \\

& #4 & \mapsto & \ds #5 \

\end{array}}

$$

| Liste chapitres |

Plan du chapitre |

| Section |  |

|

| sous-section |  |

|

|

|

| Ici sera la liste des chapitres !!! |

|

IV. Algèbre linéaire.

IV.1. Produits, sommes directes et recollement de bases.

Théorème.42

- Soient $E_1,..., E_n$ des $\SetK$-espace vectoriel, alors le produit cartésien $E_1\times...\times E_n$ muni des lois :

$$\forall \lambda\in\SetK,\:\forall (x_1,...,x_n),\:(y_1,...,y_n)\in E_1\times...\times E_n,\:\:

\left\{

\begin{array}{l}

(x_1,...,x_n)\:+\:(y_1,...,y_n)\:\=\:(x_1+y_1,...,x_n+y_n)\\[0.3cm]

\lambda.(x_1,...,x_n)\:\=\:(\lambda.x_1,...,\lambda.x_n)

\end{array}

\right.$$

est un $\SetK$-espace vectoriel.

- Si les $E_1,..., E_n$ sont de dimension finie alors :

$$\text{dim}(E_1\times...\times E_n)\=\text{dim}(E_1)\:+\:...\:+\:\text{dim}(E_n)$$

Définition-Théorème.

Soient $F_1$,..., $F_n$ des sous espaces vectoriels de $E$.

- La somme $\:F_1+...+F_n\:$ est le sous espace vectoriel de $E$ définie par :

$$F_1\:+\:...\:+\:F_n\:\=\:\Big\{\:x_1+...+x_n\:\:/\:\:\forall i\in\{1,...,n\},\:x_i\in F_i\:\Big\}$$

- La somme $\:F_1+...+F_n\:$ est directe si tout élément $x$ de $F_1+...+F_n$ se décompose de manière

unique en $x_1+...+x_n$ où chaque $x_i$ est dans $F_i$. On note $F_1\oplus...\oplus F_n$.

Théorème.43

Il y a équivalence entre:

$$\left\Updownarrow\begin{array}{l}

F_1\:\oplus\:...\:\oplus\: F_n\\[0.2cm]

x_1+...+x_n=0\:\:\:\Longrightarrow\:\:\: x_1=...=x_n=0\\[0.2cm]

\forall i\in\{1,...,n\},\:\:(F_1+...+F_{i-1}+F_{i+1}+...+F_n)\:\cap\:F_i\=\{0\}\\

\end{array}\right.$$

Remarques.

- Attention ! $F_1\oplus...\oplus F_n$ est à la fois l'ensemble $F_1+...+F_n$ et une proposition $($unicité de la décomposition$)$.

- Dans le cas $n=2$, on a :

$$F_1\oplus F_2\:\:\Longleftrightarrow\:\:F_1\cap F_2=\{0\}$$

-

Pour que la somme soit directe, $F_1\cap F_2\cap...\cap F_n=\{0\}$ ne suffit pas, ni

$F_i\cap F_j=\{0\}$ pour tout $i$ et $j$ différents. Il suffit de prendre trois droites vectorielles de $\SetR^2$

non confondues deux à deux pour avoir un contre-exemple.

Théorème - Recollement de bases.44

Soient $F_1,...,F_n$ des sev d'un $\SetK$-ev de DF $E$.

-

Notons $\beta_1$,...,$\beta_n$ des bases respectivement des sev $F_1,...,F_n$ :

$$ E=F_1\oplus...\oplus F_n\hskip0.5cm\Longleftrightarrow\hskip0.5cm \beta_1\cup...\cup\beta_n\hbox{ est une base de }E$$

où $\beta_1\cup...\cup\beta_n$ désigne la famille contenant la liste des vecteurs de $\beta_1$ puis ceux de $\beta_2$, etc... On dit que $\beta_1\cup...\cup\beta_n$ est une base de $E$ adaptée à la somme directe $F_1\oplus...\oplus F_n$

- De plus :

$$\left\{

\begin{array}{lcl}

dim(F_1\oplus...\oplus F_n)&\=&dim(F_1)\:+\:...\:+\:dim(F_n)\\[0.2cm]

dim(F_1+...+F_n)&\leq&dim(F_1)\:+\:...\:+\:dim(F_n)

\end{array}

\right.$$

De plus il y a égalité si et seulement si la somme est directe.

Remarque.

On a $\:F_1\oplus ...\oplus F_2\:\sim\: F_1\times...\times F_2\:$, puisque les dimensions sont les mêmes.

Exemple.

Ainsi, en appliquant le théorème précédent en prenant $F_1$,... $F_n$ égaux à des droites vectorielles, on trouve :

$$E\:\=\:\SetK e_1\:\oplus\:...\:\oplus\: \SetK e_n \hskip0.5cm\Longleftrightarrow\hskip0.5cm (e_1,...,e_n)\:\hbox{ est une base de }E $$

On rappelle que $\SetK e_i=Vect\{e_i\}$.

|

IV. Algèbre linéaire.

IV.2. Sommes directes en pratique.

Méthode - Comment montrer que $E= F_1\oplus...\oplus F_n$ ? 45

$${\begin{array} {|c|c|}

\hline

~&~\\[-0.3cm]

\begin{array} {c}

\text{Si on connait les dimensions des} \\

F_i\text{ et de }E\text{ et si elles sont finies.}\\

\end{array}

&\text{Sinon}\\

~&~\\[-0.3cm]

\hline\hline

~&~\\[-0.3cm]

\begin{array}{c}

\text{Etape 1}\\[0.2cm]

\text{On montre que }\:0\:\text{ se}\\

\text{décompose de manière unique dans}\\

F_1\:+\:...\:+\:F_n

\end{array}&

\begin{array}{c}

\text{Etape 1}\\[0.2cm]

\text{On montre que }\:0\:\text{ se}\\

\text{décompose de manière unique dans}\\

F_1\:+\:...\:+\:F_n

\end{array}\\[0.9cm]

\hline

~&~\\[-0.3cm]

\begin{array}{c}

\text{Etape 2}\\[0.2cm]

\text{On vérifie que :}\\

dim(E)\=dim(F_1)+...+dim(F_n)\\

~\\

\end{array}

&

\begin{array}{c}

\text{Etape 2}\\[0.2cm]

\text{On montre que tout vecteur $x$}\\

\text{se décompose dans la somme}\\

F_1\:+\:...\:+\:F_n\\

\end{array}\\[0.9cm]

\hline

\end{array}}$$

Remarque très importante.

Si $n=2$ alors on remplace l'étape 1 par $F_1\cap F_2=\{0\}$.

Exercice - Sommes directes classiques.46

- Montrer que : $$\ds\mathcal{M}_{n}(\SetR)\=S_{n}(\SetR)\oplus A_{n}(\SetR)$$

- Montrer que : $$\mathcal{F}(\SetR,\SetR)\=\mathcal{P}(\SetR,\SetR)\:\:\oplus\:\:\mathcal{I}(\SetR,\SetR)$$ avec $\:\mathcal{P}(\SetR,\SetR)\:$ et $\:\mathcal{I}(\SetR,\SetR)\:$ les $\SetR$-ev des fonctions paires et impaires de $\SetR$ dans $\SetR$.

|

IV. Algèbre linéaire.

IV.3. Rang.

Définitions.

Le rang est défini pour 3 objets mathématiques différents :

$$

\begin{array}{ll}

\Haut{0.5}\bullet\:\:\text{Pour une matrice }A\::& \text{rg}(A)\=\text{nombre de pivots.}\\

\Haut{0.7}\bullet\:\:\text{Pour une application linéaire }f\:: & \text{rg}(f)=\text{dim}(\text{Im}(f))\\

\Haut{0.7}\bullet\:\:\text{Pour une famille de vecteurs }(u_1,...,u_p)\::\:\:\: & \text{rg}(u_1,...,u_p)=\text{dim}(vect(u_1,...,u_p))\\

\end{array}

$$

Liens entre ces 3 rangs.

Soient $f\in\mathcal{L}(E,F)$ et $(u_1,...,u_p)$ une famille de $E$. Alors pour toutes bases $\beta_{_E}=(e_1,...,e_n)$ de $E$ et $\beta_{_F}$ de $F$ :

- $rg(f)\=rg\left(\Haut{0.45}\:[f]_{\beta_E\beta_F}\:\right)$

- $rg(u_1,...,u_p)\=rg\left(\Haut{0.45}\:[(u_1,...,u_p)]_{\beta_E}\:\right)$

- $rg(f)\=rg\left(\Haut{0.45}f(e_1),...,f(e_n)\right)$

Propriétés.47

- Soit $A$ dans $\mathcal{M}_{n}(\SetK)$, alors $A$ inversible si et seulement si $rg(A)=n$.

- Soit $\mathcal{F}$ une famille d'un $\SetK$-ev $E$ de DF.

- $\mathcal{F}$ est une famille libre si et seulement si $rg(\mathcal{F})$ est égal au nombre de vecteurs de $\mathcal{F}$.

- $\mathcal{F}$ est une famille génératrice de $E$ si et seulement si $rg(\mathcal{F})=dim(E)$.

- $\mathcal{F}$ est une famille base si et seulement si $rg(\mathcal{F})=dim(E)$ et si $rg(\mathcal{F})$ est égal au nombre de vecteurs de $\mathcal{F}$.

- Soit $f$ une AL de $E$ dans $F$ avec $E$ et $F$ des $\SetK$-ev de DF.

- $f$ est injective si et seulement si $rg(f)=dim(E)$.

- $f$ est surjective si et seulement si $rg(f)=dim(F)$.

- $f$ est bijective si et seulement si $rg(f)=dim(E)=dim(F)$.

Remarque.

Pour trouver le rang d'une AL, d'une famille ou d'une matrice, il suffit de se ramener au rang d'une matrice et d'utiliser le pivot de Gauss.

Exercice.48

Soit $E$ un $\SetK$-ev de dimension $n$ et $f$,

$g\in\mathcal{L}(E)$. Montrer que :

$$\begin{array} {ccccc}%

rg(f)+rg(g)-n&\:\:\leq\:\: &rg(f\:\:o\:\:g)& \:\:\leq\:\:& min(\:rg(f),rg(g)\:)\\

\Haut{0.5}\left|\:rg(f)-rg(g)\:\right|&\:\:\leq\:\: &rg(f+g)& \:\:\leq\:\:& rg(f)+rg(g)\\

\end{array}%

$$

|

IV. Algèbre linéaire.

IV.4. Le théorème du rang.

Théorème.49

-

Soit $E$ un $k$-ev de DF, $F$ un $k$-ev de dimension quelconque et $f$ une AL de $E$ dans $F$, on a alors $Im(f)$ est de DF et :

$$dim(E)\=\:rg(f)\:\:+\:\:dim(Ker(f))\hskip1cm~$$

- Soit $A$ dans $\mathcal{M}_{pq}(\SetK)$, alors :

$$q\=\:rg(A)\:\:+\:\:dim(Ker(A))$$

Conséquences.50

Dans les mêmes conditions que dans le théorème :

- Une AL conserve ou abaisse la dimension, c'est-à-dire pour tout sev $H$ de DF de $E$ :

$$dim(f(H))\:\:\leq\:\: dim(H)$$

elle la conserve pour tout sev si et seulement si $f$ injective.

- Si de plus $dim(E)=dim(F)$ alors : $$f\hbox{ injective }\hskip0.5cm\Longleftrightarrow \hskip0.5cm

f\hbox{ surjective }\hskip0.5cm\Longleftrightarrow \hskip0.5cm

f\hbox{ bijective }$$

|

IV. Algèbre linéaire.

IV.5. Invariants de similitude.

Définition - invariants pour une relation d'équivalence.

Soit $E$ un ensemble et $\sim$ une relation d'équivalence sur $E$.

- Un invariant de $\sim$ est une application dont $E$ est l'espace de départ et qui est constante sur les classes d'équivalence. Formellement, l'application $f$ est un invariant si et seulement si : $$\forall x\in E,\:\:\: x\sim y\:\:\Longrightarrow\:\: f(x)=f(y)$$

- Un invariant idéal de $\sim$ est une application qui sépare les classes c'est-à-dire une application $f$ telle que : $$\forall x\in E,\:\:\: x\sim y\:\:\Longleftrightarrow\:\: f(x)=f(y)$$

Remarques.

- A quoi sert un invariant ? Il sert à vérifier que 2 éléments ne sont pas équivalents. En effet si $f(x)\neq f(y)$ alors $x\sim\!\!\!\!\!\!/\:\:y$. Un invariant $($non idéal$)$ ne peut pas servir à montrer que des éléments sont équivalents.

- A quoi sert un invariant idéal ? Il sert à vérifier que 2 éléments sont ou ne sont pas équivalents. En effet si $f(x)=f(y)$ alors $x\sim y$, sinon $x\sim\!\!\!\!\!\!/\:\:y$.

- Quand on a une relation d'équivalence, on cherche un invariant idéal. Si on en trouve un, on s'arrête. Si on n'en a pas, on cherche autant d'invariants que possible en espérant que la quantité remplace le manque de qualité.

Propriétés.51

- Le rang, le déterminant et la trace sont des invariants pour la relation $\sim$. On dit que ce sont des invariants de similitude. Aucun d'eux n'est un invariant idéal.

- Le rang est un invariant pour les relations $\simL$, $\simC$ et $\simLC$ $($Attention ce n'est pas le cas pour le déterminant et la trace$)$.

- Le rang est un invariant idéal pour la relation $\simLC$, cad que pour $A$ et $B$ dans $\mathcal{M}_{pq}(\SetK)$

$$A\:\simLC\: B\hskip0.5cm\Longleftrightarrow\hskip0.5cm rg(A)\=rg(B) $$

Définition.

Soit $u$ un endomorphisme, on appelle $det(u)$ le déterminant de l'une de ses matrices $($peut importe laquelle puisque $det$ est un invariant de similitude$)$. De même on définit $tr(u)$ la trace de l'une de ses matrices. On peut rééditer l'exploit à chaque fois que l'on découvre un invariant de similitude.

Méthode.52

Soit $A$ et $B$ dans $\mathcal{M}_n(\SetK)$.

- Comment montrer que $A$ et $B$ ne sont pas semblables ? On montre que $\:det(A)\neq det(B)\:\:$ ou $\:\:rg(A)\neq rg(B)\:\:$ ou $\:\:tr(A)\neq tr(B)\:$.

- Comment montrer que $A$ et $B$ sont semblables ? On considère l'AL canoniquement $f_{_A}$ associée à $A$ et on montre qu'il existe une base dans laquelle la matrice de $f_{_A}$ est $B$.

Exercice.53

- Montrer que les matrices $A$ et $B$ ne sont pas semblables dans les 3 cas suivants :

$$\begin{array}{|c||c|c|c|}

\hline

&Cas 1&Cas 2&Cas 3\rule[-7pt]{0pt}{20pt}\\

\hline

~\hskip0.7cmA\hskip0.7cm~&

~\hskip0.3cm\left(\begin{array}{cc}1&1\\ 1&4\end{array}\right)\hskip0.3cm~&

~\hskip0.3cm\left(\begin{array}{ccc}0&0&0\\ 0&2&0\\0&0&-1\end{array}\right)\hskip0.3cm~&

~\hskip0.3cm\left(\begin{array}{cc}3&0\\ 0&1\end{array}\right)\hskip0.3cm~\rule[-25pt]{0pt}{60pt}\\

%

\hline B&

\left(\begin{array}{cc}2&1\\ 1&2\end{array}\right)&

\left(\begin{array}{ccc}0&0&0\\ 0&0&0\\0&0&1\end{array}\right)&

\left(\begin{array}{cc}2&0\\ 0&2\end{array}\right)\rule[-25pt]{0pt}{60pt}\\

\hline

\end{array}$$

- Montrer que :

$$\left(\begin{array}{cc}0&-2\\ 1&3\end{array}\right)\:\:\:\sim\:\:\:

\left(\begin{array}{cc}2&2\\ 0&1\end{array}\right)$$

|

IV. Algèbre linéaire.

IV.6. Projections et symétries.

Définitions.

Soit $E$ un $\SetK$-ev et $F$, $G$ des sev de $E$ tels que $E=F\oplus

G$. Tout $x$ de $E$ se décompose alors de manière unique en

$x_1+x_2$ avec $x_1\in F$ et $x_2\in G$.

-

L'application $p$ qui a

$x$ associe $x_1$ est appelée projection sur $F$ de direction

$G$. On a donc : $$\fonction{p}{F\oplus G}{E}{x_1+x_2}{x_1}$$

-

L'application $s$ qui a

$x$ associe $x_1-x_2$ est appelée la symétrie par rapport à $F$ de direction $G$. On a donc :

la fonction :

$$\fonction{s}{F\oplus G}{E}{x_1+x_2}{x_1-x_2}$$

Théorème.54

Soit $E$ un $\SetK$ espace vectoriel.

- Soit $p$ une application de $E$ dans $E$ alors

$$p\text{ est une projection de }E\hskip0.5cm\Longleftrightarrow\hskip0.5cm

\left\{\:\begin{array}{l}

p\text{ est une application linéaire,}\\

p\:o\:p\=p\\

\end{array}\right.

$$

De plus $p$ est une projection sur $Im(p)=Ker(p-Id)$ par rapport à $Ker(p)$.

- Soit $s$ une application de $E$ dans $E$ alors

$$s\text{ est une symétrie de }E\hskip0.5cm\Longleftrightarrow\hskip0.5cm

\left\{\:\begin{array}{l}

s\text{ est une application linéaire,}\\

s\:o\:s\=Id_{_E}\\

\end{array}\right.

$$

De plus $s$ est une symétrie par rapport $Ker(s-Id)$ parallèlement à $Ker(s+Id)$.

- Soit $F$ et $G$ des sev de $E$ vérifiant $E=F\oplus G$. Notons $s$ la symétrie par rapport à $F$ et de direction $G$ et $p$ la projection sur $F$ par rapport à $G$. On a alors :

$$s\=2p-Id$$

Remarque très utile.

Si $p$ est la projection sur $F$ de direction $G$ alors $Id-p$ est la projection sur $G$ de direction $F$.

Exercice.55

Soit $p$ une projection d'un espace vectoriel de dimension finie. Montrer que : $\:tr(p)=rg(p)$.

Exercice.56

Soit $E=\mathcal{F}(\SetR, \SetR)$. Notons par $\phi$ l'application de $E$ dans $E$ définie par :

$$\forall f\in E,\:\forall x\in\SetR,\:\:\:\phi(f)(x)\=f(-x)$$

Montrer que $\phi$ est une symétrie dont vous donnerez les éléments caractéristiques. Quelle est la projection associée ?

|

IV. Algèbre linéaire.

IV.7. Formes linéaires et hyperplans.

Définitions.

Soit $E$ un $\SetK$-ev de dimension finie.

-

Un sev $\:H\:$ de $\:E\:$ est un hyperplan de $\:E\:$ si et seulement sa dimension est égale à $\:dim(E)-1$.

-

L'espace dual de $\:E\:$ est $\:E^*=\mathcal{L}(E,\SetK)\:$. Ainsi $E^*$ contient l'ensemble des formes linéaires de $E$.

Remarques.

- Les hyperplans en dimension 2 sont les droites vectorielles.

- Les hyperplans en dimension 3 sont les plans vectoriels.

- $dim(E^*)\=dim\left(\mathcal{L}(E,\SetK)\right)\=dim(E)$

Théorème - Liens entre formes linéaire et hyperplans.57

Soit $\:E\:$ un espace vectoriel $($de dimension finie$)$.

- Le noyau d'une forme linéaire non nulle est un hyperplan.

- Inversement, tout hyperplan est le noyau d'au moins une forme linéaire non nulle.

- Les formes linéaires non nulles ayant le même hyperplan pour noyau sont proportionnelles.

Théorème - Equation d'un hyperplans.58

Soit $E$ un espace vectoriel de dimension finie. On se place dans une base de $E$.

- Les coordonnées $(x_1,...,x_n)$ des vecteurs d'un hyperplan en DF sont exectement les solutions d'une équation du type :

$$a_1x_1\:\:+\:\:...\:\:+\:\:a_nx_n\:\=\:0$$

avec $(a_1,...,a_n)\neq(0,,...,0)$.

- Inversement les solutions d'une équation de ce type forment un hyperplan.

- Deux équations d'un hyperplan représentent le même hyperplan si et seulement si les équations sont proportionnelles.

Remarques.

- Le premier théorème est encore vrai en dimension infinie à condition d'étendre la définition des hyperplans. Pas le second puisqu'on se place dans une base.

- Les droites vectorielles en dimension 2 sont de la forme $\:ax+by=0\:$ avec $\:(a,b)\neq(0,0)\:$

- Les plans vectoriels en dimension 3 sont de la forme $\:ax+by+cz=0\:$ avec $\:(a,b,c)\neq(0,0,0)\:$

- Les droites vectorielles en dimension 3 sont de la forme :

$$\left\{\begin{array} {ccccccc}%

a_1x&+&b_1y&+&c_1z&=&0\\

a_2x&+&b_2y&+&c_2z&=&0\\

\end{array}%

\right.$$

avec $(a_1,b_1,c_1)$ et $(a_2,b_2,c_2)$ non proportionnelles $($On les exprime comme l'intersection de 2 plans sécants distincts$)$.

Exercice.59

Posons $H= \left\{\Haut{0.4}P\in\SetR_n[X]\:/\:P(1)=0\:\right\}$.

- Montrer que $H$ est un hyperplan.

- Déterminer une équation de $H$ dans la base canonique.

- Déterminer toutes les formes linéaires ayant $H$ pour noyau.

|

IV. Algèbre linéaire.

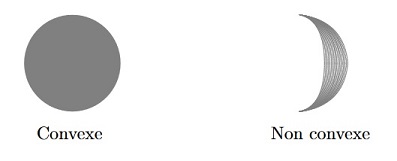

IV.8. Parties convexes.

Définitions.

- Soit $x$ et $y$ dans $E$. Le segment $[x,y]$ est l'ensemble :

$$[x,y]\=\left\{\:\Haut{0.48}\lambda.x+(1-\lambda).y\:\:\:/\:\:\:\lambda\in[0,1]\:\right\}$$

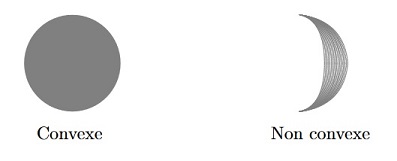

- Une partie $A$ de $E$ est convexe ssi pour tous $x$, $y$ de $A$, le segment $[x,y]$ est encore dans $A$. Ainsi $A$ est convexe si et seulement si :

$$\forall x,y\in A,\:\:\forall\lambda\in[0,1],\:\:\:\lambda.x\:+\:(1-\lambda).y\:\:\in\:\:A$$

- Un combinaison linéaire convexe (CLC) de $x_1,...,x_n$ dans $E$ est une expression du type

$\:\:\lambda_1 x_1+...+\lambda_n x_n\:\:$

avec $\:\:\lambda_1+...+\lambda_n =1\:\:$

et $\:\:\lambda_1,...,\lambda_n\:\:$ dans $\SetR^+$.

- Un ensemble $A$ est stable par CLC ssi pour tous $x_1,... x_n$ de $A$ les CLC de $x_1,...,x_n$ sont encore dans $A$.

- Soit $A$ une partie de $E$. On note $Conv(A)$ le plus petit convexe contenant $A$. C'est l'enveloppe convexe de $A$

Exemples.

Dans $\SetR^2$ :

Théorème.60

- $\emptyset$ est convexe.

- $A$ est convexe ssi $A$ est stable par CLC

- L'intersection de convexes est encore un convexe.

- Les espaces vectoriels et les boules d'un evn sont convexes.

- Pour toute partie $A$, l'enveloppe convexe $conv(A)$ est l'ensemble des CLC que l'on peut former avec des éléments de $A$.

Exercice.61

Montrer que $A=\left\{\:\left[\begin{array} {ccc}%

a&b\\

c&d\\

\end{array}%

\right]\:\:\:/\:\:\:a+b+c+d=1\:\right\}$ est convexe. Est-ce un espace vectoriel ?

Exercice.62

Montrer que l'ensemble des polynômes à coefficients positifs est convexe.

Exercice.63

Montrer que dans $\SetR$, les convexes sont exactement les intervalles.

Exercice.64

On dit qu'une matrice de $\mathcal{M}_n(\SetR)$ est une matrice stochastique si :

- Tous les coefficients de $M$ sont dans $[0,1]$,

- La somme des coefficients d'une même ligne fait 1.

- Posons $U$ la matrice colonne ne contenant que des 1. Montrer qu'une matrice $A$ de $\mathcal{M}_n(\SetR^+)$ est une matrice stochastique si et seulement si $AU=U$.

- Montrer que l'ensemble des matrices stochastiques est un convexe de $\mathcal{M}_{n}(\SetC)$.

|